SVBENCH: A BENCHMARK WITH TEMPORAL MULTI-TURN DIALOGUES FOR STREAMING VIDEO UNDERSTANDING

作者与单位

本文来自自动化所和快手, 是由一作在快手实习期间完成的. 一作似乎也是北邮校友

摘要

研究背景

长时序流式视频理解(streaming video understanding) 这个新兴领域,缺少合适的评测标准

现有的视频理解基准:

- 大多只关注单轮问题回答(single-instance QA)

- 无法有效评估模型在完整视频流过程中的时序推理能力

论文贡献

一个评测基准:

- SVBench:一个流式视频理解评测基准

- 设计了时间连续的多轮问答链(temporal multi-turn question-answering chains),全面评估 LVLMs 在流式视频理解中的能力

一个模型: - StreamingChat(开源)

- 在 SVBench 上显著优于现有开源模型,且在其他视觉语言基准上表现也非常不错。

实验结果

- GPT-4o(封闭源)表现最好

- 大多数开源 LVLMs 在长时序流式视频理解方面表现较差

引言

研究背景

LVLM快速发展, 但是多数用于离线视频

而现实中多为流式视频, 模型无法看到未来, 只能边看边理解

现有基准局限

- 现实场景中:

- 用户通常会在视频流过程中提出多个相关问题,涉及上下文历史。

- 现有多轮对话基准:

- 要么基于静态图片序列

- 要么基于短视频

- 缺乏 真实流式视频 + 长时序对话 的场景

核心贡献

- 设计时序多轮对话

- 建立时序联系

- 构建数据集

相关工作

LVLM

当前模型有一些不足:

- 尚未完全掌握流式视频的复杂时序特征

- 多数模型不能连续理解视频时间流,无法应对复杂真实场景中的信息流

视频理解基准

- 即使是长视频数据集:

- 多数忽略了流式视频的时序连续性和动态场景变化

- 现有基准不能:

- 测试模型在连续场景中的时序推理能力

- 测试模型在多轮连续对话中的上下文记忆能力

数据集

数据构建

作者设计了一套半自动标注流程

- 数据筛选: 时长, 美学评分, 光流评分

- 场景检测与切分: 保证视频节奏合理, 内容丰富

- 构建 QA 链: 每个问题必须基于前一个回答, 依靠模型生成+人工修改

- QA 质量评估: 用其他模型评估 QA 链质量, 进行筛选

- 时序链接 : 基于一些关系建立跨片段时间关系

- QA 时序调整: 确保问答链具有高复杂度推理价值

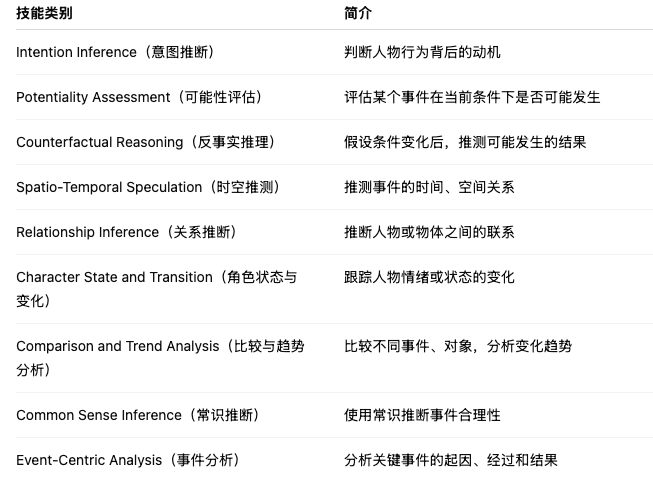

类别设计

- 意图推断(Intention Inference)

- 可能性评估(Potentiality Assessment)

- 反事实推理(Counterfactual Reasoning)

- 时空推测(Spatio-Temporal Speculation)

- 关系推断(Relationship Inference)

- 角色状态与变化(Character State and Transition)

- 比较与趋势分析(Comparison and Trend Analysis)

- 常识推断(Common Sense Inference)

- 事件分析(Event-Centric Analysis)

关键创新

- 首次构建针对流式视频连续多轮对话的大规模数据集

- 每个视频的 QA 链不仅覆盖视频片段,还跨片段建立时序关系,逼近真实直播场景

- 提供完整标注流程,可复现、可扩展、公开可用

统计分析

数据规模

SVBench 是目前已知视频问答数据集中 单视频 QA 数量最多的,远超之前的数据集

视频类别

- 共 12 个主类别

- 每个主类别下包含 36 个子类别

场景多, 全面测试模型的泛化能力

问题技能类别

StreamingChat

模型架构

| 组件 | 说明 |

|---|---|

| 视觉编码器(Vision Encoder) | 使用 InternViT,从视频帧中提取图像特征(1 FPS 采样率) |

| 投影层(MLP Projector) | 将视觉特征转化为语言模型可以处理的 token |

| 大语言模型(LLM) | 使用 InternLM2,支持长上下文输入,处理视觉和文本 token |

技术细节:

- 使用 静态分辨率处理策略:

- 可以支持长视频的连续输入,上下文窗口最大支持 32k tokens。

- 每个视频采样 1 FPS 帧,经过视觉编码后:

- 送入 MLP 投影,转换成 frame token。

- 这些 frame token 与语言 token 混合输入到大语言模型中。

- 使用 LoRA(Low-Rank Adaptation)微调技术:

- 在 LLM 的每一层线性层插入 LoRA,提高训练效率,降低显存消耗。

训练数据

使用 SVBench 中的训练集进行监督微调

创新点

- 视觉-语言融合输入:

- 将视觉 token 与语言 token 混合输入,支持多轮时序对话

- 长上下文支持:

- 静态分辨率策略 + LoRA 微调,让模型可以高效处理几分钟长度的视频

- 针对流式视频优化:

- 训练过程中严格按照视频时间线进行片段输入,模拟真实流式视频对话

实验

实验设置

评测模式

| 评测类型 | 重点能力 | 描述 |

|---|---|---|

| Dialogue Evaluation(对话评测) | 上下文连贯性 | 模型输入当前片段及其全部历史 QA,上下文线性流动,测试多轮对话能力 |

| Streaming Evaluation(流式评测) | 时序跳转推理 | 在对话评测基础上,加入 80% 概率时序跳跃,测试跨片段推理和时序理解能力 |

评测指标

- 基本指标: 传统文本指标, 语义/文本相似度

- 对话评测框架:

| 指标 | 含义 |

|---|---|

| Semantic Accuracy (SA) | 语义准确性,回答是否准确且符合上下文 |

| Contextual Coherence (CC) | 上下文连贯性,回答是否在整个对话链中合理 |

| Logical Consistency (LC) | 逻辑一致性,回答是否与历史信息矛盾 |

| Temporal Understanding (TU) | 时序理解,是否正确理解事件顺序与因果关系 |

| Informational Completeness (IC) | 信息完整性,回答是否包含关键细节 |

| Overall Score (OS) | 综合得分,综合以上五项指标 |

整体结果

- GPT-4o 是现阶段最佳模型。

- StreamingChat 在所有 开源模型中表现最优

- StreamingChat 即使专门针对流式视频进行了训练,在传统图像和视频基准上几乎没有性能损失

视频理解技能分析

- GPT-4o 在所有技能类别上表现最好

- StreamingChat:

- 全面超越所有开源模型

- 在可能性评估(PA)、角色状态变化(CST)、事件分析(ECA)这三个技能类别甚至超过了 GPT-4o

模型普遍弱点:

- 反事实推理(CR)

- 时空推测(STS)

- 这类任务需要复杂的假设与时间轴推理,现有 LVLMs 尚未掌握

消融实验

- 多轮 QA(包含上下文)显著提升了模型表现

- 证明了对话链式输入对于视频理解任务的重要性

结论

提出 SVBench:流式视频理解新基准

- SVBench 是第一个专门针对 流式视频时序多轮对话 设计的 benchmark

- 数据集设计:

- 强调视频片段之间的时间连续性

- 每个 QA 链之间存在跨片段、时序关联,逼近真实场景

提出 StreamingChat 模型

- 设计了一个适配流式视频场景的 开源 LVLM:StreamingChat

- StreamingChat 显著超越了现有开源模型:

- 在 SVBench 上表现最佳

- 在其他主流视觉语言任务上也保持了良好的综合能力

关键发现

- 当前主流 LVLMs 在 传统短视频或静态图像任务上表现良好,但在 长时序流式视频理解任务中明显不足

- 多轮 QA 场景显著优于传统单轮 QA 评测,表明:

- 流式视频任务必须设计 上下文强依赖、多轮对话的复杂任务场景,才能真实考察模型能力