服务器

连接服务器

- 学长给了我服务器的账号密码, 直接在 vscode 中选择远程连接即可

- 需要提前安装 remote 插件, 不过一般都预装好了

- 需要提前把账号相关信息写到 config 文件当中, 然后直接F1, 选择对应服务器, 填写密码即可

部署模型

这里我需要部署的是 SV-Bench 论文中的 StreamingChat 模型, 在 huggingface 上 release 了

huggingface 换源

有的服务器没有更换全局的下载源, 比如我现在用的

因此需要手动换源, 到镜像站上去找对应的模型

HF-Mirror

处理LFS

我部署的这个模型里面有大文件, 用的是 git LFS, 走的还是国外连接, 因此需要先下载 LFS 之外的文件, 然后对 lfs 单独处理, 再下载

配环境

我看的这个模型还好, 他给出了配环境的相关要求和代码

不过还是和服务器有不兼容的问题, 比如版本之类的

我的处理方法是丢给 gpt, 然后把相关的一些信息给他, 让他一步步教我如何配, 怎么解决冲突.

卡编译

在安装 flash-attn 的时候, 编译环节卡住久久不动

用 gpt 给的几种方法都卡在相同位置

最后使用预编译的版本

CUDA out of memory

自己跑模型的时候需要注意有没有空闲的卡, 不然就会出现这种跑不了的情况.

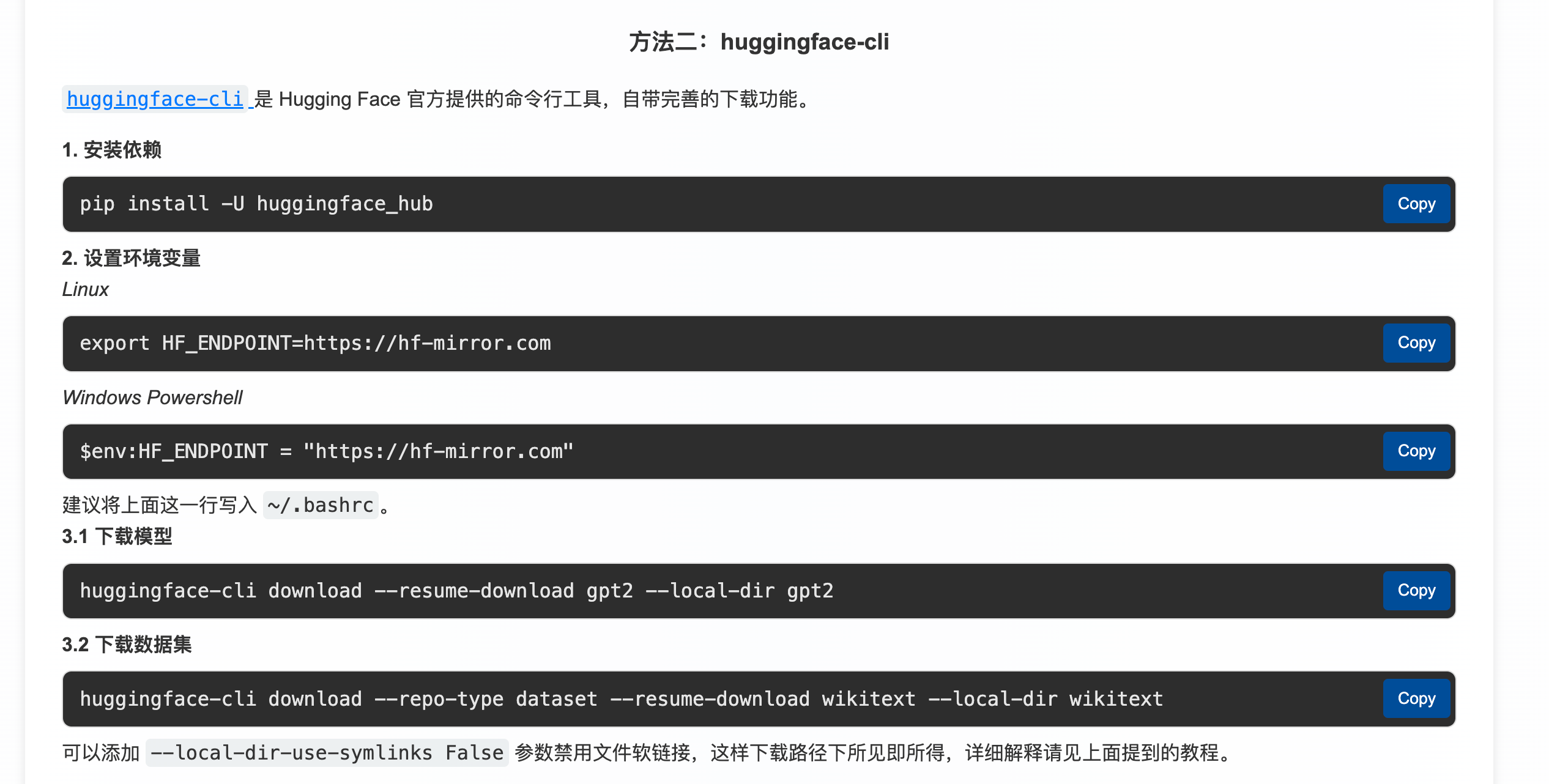

HF - CLI

后来即使换源也无法解决下载大文件时卡死的问题, 使用 huggingface-cli 后发现效果很好

大概就是这样